Dirbtinis intelektas - istorija

Dirbtinis intelektas (DI) šiandien yra viena iš sparčiausiai besivystančių technologijų sričių, tačiau jo šaknys siekia kur kas giliau, nei daugelis suvokia. DI istorija – tai ambicingų svajonių, intelektinių proveržių ir technologinių revoliucijų istorija, kuri palaipsniui keitė mūsų požiūrį į technologijas ir jų naudojimą.

Ankstyvas dirbtinio intelekto mašinų konceptas

Dirbtinio intelekto idėjos pagrindus galima atsekti iki senovės laikų, kai filosofai, tokie kaip Aristotelis, svarstė apie logikos mąstymo mechanizmus. Jau antikos mituose ir pasakojimuose pasirodė dirbtinių būtybių vaizdiniai – pavyzdžiui, Hefaisto, graikų kalvystės dievo, automatonai.

Pirmosios praktinės mintys apie „mechaninį smegenų“ modelį atsirado XVII ir XVIII amžiuje kartu su mechaninių skaičiavimo mašinų, tokių kaip Blaiso Paskalio ar Čarlzo Babidžo išradimai, kūrimu. Šios mašinos turėjo ribotas galimybes ir buvo toli nuo tikrosios dirbtinio intelekto idėjos.

Moderniojo DI gimimas (1940–1960 m.)

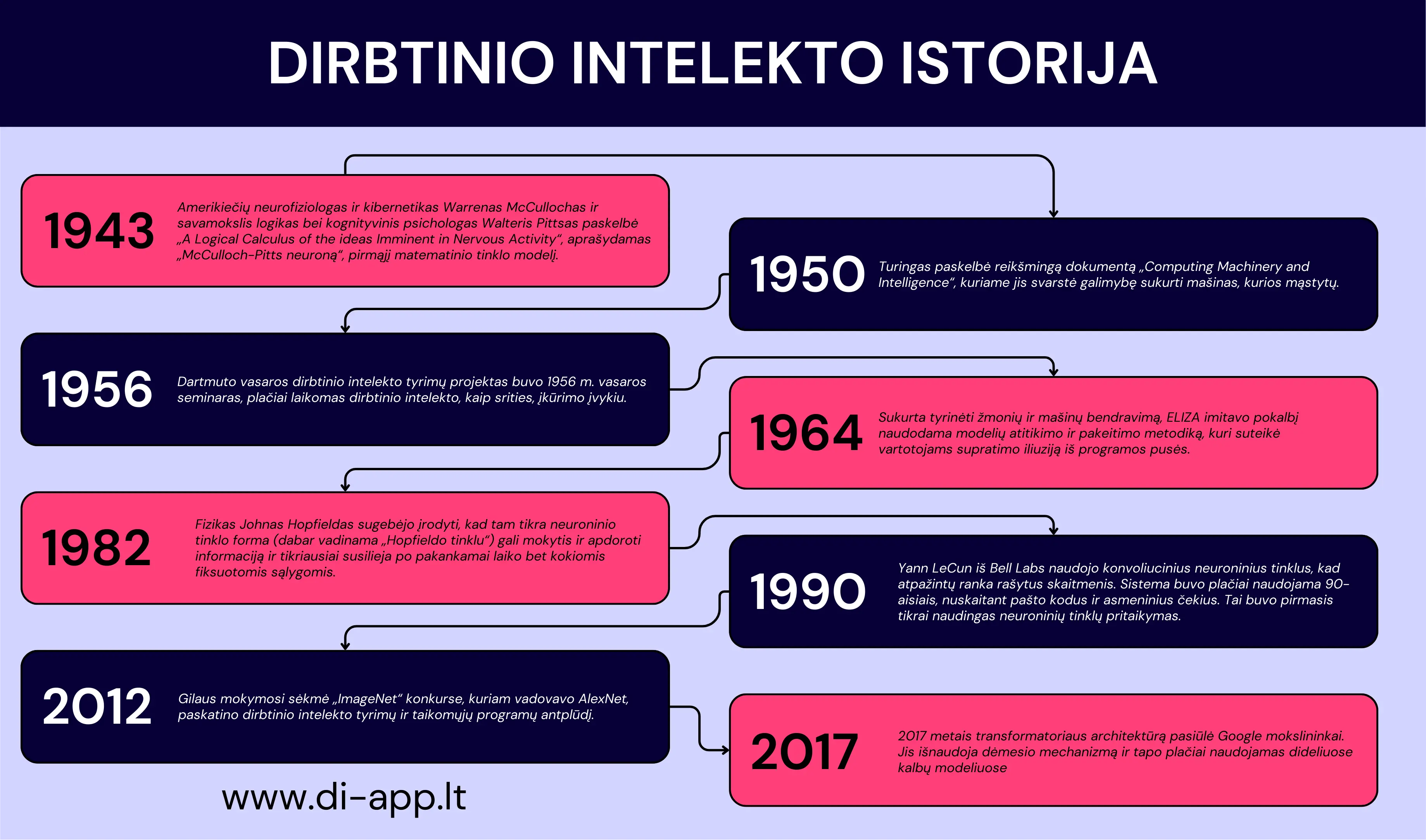

XX a. 4–6 dešimtmečiai buvo lemiamas moderniojo dirbtinio intelekto atsiradimo laikotarpis. Šiuo metu buvo suformuluoti pagrindiniai teoriniai principai, kurie iki šiol sudaro šios srities pagrindą. Pagrindiniai šio laikotarpio vizionieriai, apjungę matematiką, logiką, filosofiją ir inžineriją, atvėrė kelią mašininio intelekto tyrimams.

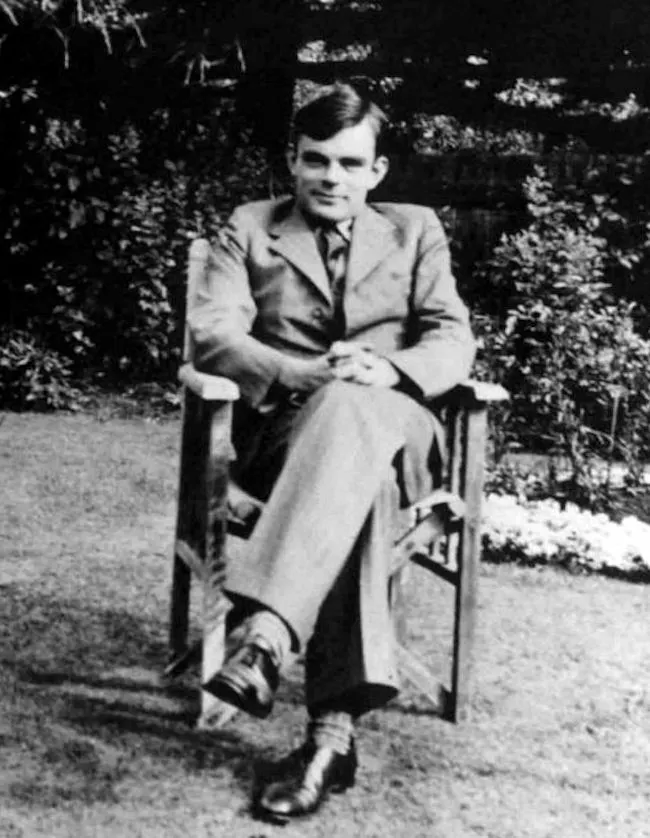

Alanas Turingas: Matematikos genijus ir vizionierius

Vienas pagrindinių pradininkų buvo britų matematikas Alanas Turingas. Jo darbas Antrojo pasaulinio karo metu, iššifruojant Enigmos kodus, parodė, kaip skaičiavimo mašinos gali atlikti sudėtingas logines operacijas. 1936 m. Turingas pristatė Turingo mašinos koncepciją – teorinį įrenginį, galintį simuliuoti bet kokį algoritmą. Ši idėja tapo moderniųjų kompiuterių pagrindu ir iškėlė klausimus, ar mašinos gali ne tik skaičiuoti, bet ir „mąstyti“.

1950 m. Turingas paskelbė savo garsųjį straipsnį „Skaičiavimo mašinos ir intelektas“, kuriame uždavė esminį klausimą: „Ar mašinos gali mąstyti?“ Jis pristatė Turingo testą – eksperimentą, skirtą patikrinti, ar mašina gali demonstruoti nuo žmogaus neatskiriamą intelektinį elgesį. Turingo testas tapo vienu pirmųjų bandymų apibrėžti DI tyrimų tikslus ir kriterijus.

Kibernetika ir tarpdisciplininiai metodai

4-ajame dešimtmetyje vyko diskusijos apie skaičiavimo technikos ir biologijos sąsajas. Matematikas ir filosofas Norbertas Vineris įvedė kibernetikos sąvoką ir tyrinėjo, kaip biologijos grįžtamojo ryšio bei prisitaikymo principus galima pritaikyti mašinoms. Kibernetika įkvėpė pirmuosius neuroninių tinklų modelius ir padėjo pamatus sistemų, gebančių mokytis, supratimui.

Tuo pačiu metu buvo atlikti pirmieji nervų sistemos simuliacijos bandymai. 1943 m. Vorenas Makulokas ir Volteris Pitsas paskelbė straipsnį apie neuroninių tinklų matematinį modelį. Jie parodė, kad paprastos dvejetainės vienetės (neuronai) gali atlikti logines operacijas ir teoriškai simuliuoti žmogaus mąstymą. Šis požiūris įkvėpė vėlesnę mašininio mokymosi plėtrą.

Pirmieji kompiuteriai ir programos

Pokario metais buvo reikšmingai pažengta skaičiavimo technikoje. Pirmųjų elektroninių kompiuterių, tokių kaip ENIAC (1945 m.), sukūrimas sudarė galimybes teorinėms idėjoms įgyvendinti praktiškai. Džonas fon Neimanas, pagrindinė šios eros figūra, sukūrė kompiuterio architektūrą, kuri iki šiol yra naudojama (von Neimano architektūra).

1951 m. buvo sukurtas pirmasis programa, galinti žaisti žaidimus – Klodo Šanono ir Allano Newello šachmatų algoritmas. Šie eksperimentai parodė, kad kompiuterius galima programuoti spręsti specifines užduotis – tai buvo pirmasis praktinis mašinų intelektinio elgesio demonstravimas.

Dartmuto konferencija 1956 m.: Oficiali DI pradžia

Oficialia moderniojo DI pradžia laikoma 1956 m. Dartmuto koledže vykusi konferencija, kurią organizavo Džonas Makartis kartu su Marvinu Minskio, Natanu Ročesteriu ir Klodu Šanonu. Šioje konferencijoje pirmą kartą buvo panaudotas terminas „dirbtinis intelektas“. Tikslas buvo suformuluoti pagrindinius DI tyrimų klausimus ir plėtros kryptį.

Konferencijos dalyviai tikėjo, kad raktas į intelektualių mašinų kūrimą yra matematinė logika ir pakankama skaičiavimo galia. Iš konferencijos kilo keletas svarbių koncepcijų, pavyzdžiui, formalizuoto programavimo naudojimas problemoms spręsti arba idėja simuliuoti žmogaus intelektą per algoritmus.

Optimistinės nuotaikos ir pirmieji pasiekimai

5-ojo dešimtmečio pabaigoje DI tyrimai įžengė į ankstyvųjų eksperimentų fazę. Programos, tokios kaip Logic Theorist (1956 m.), sukurta Alleno Niuelio ir Herberto Simono, buvo pirmoji sistema, galėjusi įrodyti matematinius teiginius. Ši programa parodė, kad mašinos gali atlikti užduotis, anksčiau laikytas išskirtinai žmogaus gebėjimais.

Kitas pasiekimas buvo programų, tokių kaip ELIZA, sukūrimas – tai buvo pirmasis pokalbių robotas, simuliavęs psichoterapinį pokalbį. Nors tai buvo labai primityvios programos, jos parodė potencialą, kur link gali vystytis DI.

Šios eros reikšmė ir įtaka

1940–1960 m. laikotarpis padėjo tvirtus moderniojo dirbtinio intelekto pagrindus. Buvo sukurti teoriniai modeliai, sukurti pirmieji kompiuterių algoritmai ir iškelti nauji moksliniai klausimai. Nors tuo metu tikrasis intelektas dar buvo tolimas tikslas, ši era apibrėžė viziją, kuri įkvėpė būsimąsias mokslininkų ir inžinierių kartas.

Auksinis amžius ir pirmieji nusivylimai (1960–1980)

Šeštasis–aštuntasis XX a. dešimtmečiai dirbtinio intelekto (DI) istorijoje pasižymi sparčiu vystymusi, tačiau taip pat ir pirmosiomis didelėmis nesėkmėmis. Optimizmas, lydėjęs DI tyrimų pradžią, skatino ambicingus projektus ir dideles investicijas. Tačiau tuometinių technologijų apribojimai ir per dideli lūkesčiai lėmė, kad ši era pasižymi tiek pasiekimais, tiek nesėkmėmis.

Optimizmo augimas: DI kaip nauja mokslo riba

XX a. šeštojo dešimtmečio pradžioje mokslininkai ir inžinieriai buvo įsitikinę, kad protingų mašinų sukūrimas yra ranka pasiekiamas. Teorijos ir praktikos plėtra atnešė keletą žymių pasiekimų, kurie skatino tikėjimą greitu progresu:

- Ekspertinės sistemos:

- Dendral (1965): Pirmoji ekspertinė sistema, sukurta molekulių cheminės analizės srityje. Ši sistema, naudodama chemikų darbo pagrindu sukurtas taisykles, prognozavo molekulinę struktūrą.

- MYCIN (1970 m. dešimtmetis): Sistema, skirta infekcinių ligų diagnostikai ir antibiotikų rekomendacijoms. MYCIN tapo pirmosios DI taikymo medicinoje kartos ikona.

Ekspertinės sistemos, imituojančios specialistų sprendimų priėmimą tam tikrose srityse, tapo pagrindiniu DI taikymu ir buvo naudingos pramonėje bei sveikatos apsaugoje.

Žaidimų žaidimas:

- Šeštajame dešimtmetyje buvo sukurta programų, galinčių gana aukštu lygiu žaisti šachmatais ir šaškėmis. Pavyzdžiui, Herberto Simono ir Alleno Newello šachmatų programa galėjo nugalėti mėgėjus.

DI programavimo kalbos:

- Johnas McCarthy 1958 m. sukūrė LISP kalbą, kuri tapo standartine DI programavime. LISP leido efektyviai kurti sudėtingus algoritmus ir buvo naudojama daugelyje tyrimų projektų.

Problemos, kurių DI negalėjo įveikti

Nepaisant žymių pasiekimų, atsirado pagrindinių kliūčių, kurios atskleidė tuometinių technologijų ribas:

Skaičiavimo galios trūkumas:

- Šeštojo ir septintojo dešimtmečių kompiuteriai turėjo ribotą skaičiavimo galią ir atmintį. Daug algoritmų buvo itin skaičiavimo intensyvūs, todėl net paprastiems uždaviniams spręsti reikėjo daug laiko.

Žinių problema:

- Ankstyvosios DI sistemos, ypač ekspertinės, rėmėsi rankiniu būdu sukurtomis taisyklėmis. Šių taisyklių kūrimas buvo lėtas ir brangus, o be to, paaiškėjo, kad žmogaus žinios yra daug sudėtingesnės nei tikėtasi.

Ribotos mašininio mokymosi galimybės:

- Nors neuroniniai tinklai buvo pristatyti dar 1940-aisiais, jų plėtra buvo pradinėje stadijoje. Trūko duomenų ir skaičiavimo galios, kad būtų galima treniruoti tinklus praktiniais rezultatais.

DI „žiema“: pirmieji nusivylimai

Optimistinės XX a. šeštojo dešimtmečio prognozės, kad bendrosios dirbtinės inteligencijos (AGI) sukūrimas yra tik kelių metų klausimas, neišsipildė. Septintojo dešimtmečio pabaigoje paaiškėjo, kad DI problemos yra daug sudėtingesnės:

Finansavimo sumažėjimas:

- Vyriausybinės agentūros, tokios kaip JAV DARPA, prarado kantrybę dėl lėto progreso. Daugelis projektų buvo nutraukti, nes neatitiko lūkesčių.

Pasitikėjimo praradimas:

- Bloga viešoji nuomonė ir nerealūs pažadai sukėlė nepasitikėjimą DI sritimi. Kritikai pradėjo vadinti DI „prarastu mokslu“, o skeptikai teigė, kad mašinos negali iš tikrųjų „mąstyti“.

Akademinė kritika:

- Marvinas Minsky ir Seymouras Papertas 1969 m. išleido knygą Perceptrons, kurioje pabrėžė tuo metu esančių neuroninių tinklų modelių pagrindinius apribojimus. Šis darbas laikinai sumažino susidomėjimą neuroninių tinklų tyrimais.

Naujos kryptys ir pamokos iš nesėkmių

Nepaisant šių nusivylimų, šis laikotarpis suteikė svarbių įžvalgų, kurios turėjo įtakos tolimesnei raidai:

Dėmesys specializuotoms sistemoms:

- Vietoj bandymų sukurti bendrąją inteligenciją (AGI), mokslininkai pradėjo koncentruotis į vadinamąjį „silpnąjį DI“ – sistemas, skirtas spręsti konkrečias problemas.

Tarpdisciplininių tyrimų augimas:

- Matematikos, biologijos, lingvistikos ir psichologijos įtaka sustiprino DI teorinius pagrindus.

Mašininio mokymosi pagrindai:

- Nors mašininis mokymasis tuo metu nebuvo plačiai taikomas, jis tapo pagrindu būsimai raidai 1980–1990 m.

1960–1980 m. laikotarpį galima apibūdinti kaip pirmosios entuziazmo bangos ir vėlesnio nusivylimo erą. Nors daug ambicijų liko neįgyvendintos, tyrimai šiuo laikotarpiu sukūrė tvirtą pagrindą būsimai pažangai. DI išmoko dirbti su specializuotomis užduotimis, o tyrėjai suvokė, kad tikrosios inteligencijos pasiekimui reikalingos ne tik galingesnės technologijos, bet ir gilesnis žmogaus mąstymo supratimas.

Dirbtinio intelekto renesansas (1980–2000 m.)

Po laikotarpio, žinomo kaip AI žiema (dirbtinio intelekto žiema), kai susidomėjimas AI tyrimais sumažėjo dėl nerealistinių lūkesčių ir techninių apribojimų, 9-ajame dešimtmetyje įvyko šios srities atsigavimas. Šis laikotarpis, dažnai vadinamas dirbtinio intelekto renesansu, pasižymėjo naujų metodų atsiradimu, geresniu teorinių pagrindų supratimu ir praktinėmis programomis. Ypač svarbų vaidmenį suvaidino ekspertų sistemos, atnaujintas susidomėjimas neuroniniais tinklais ir naujų tyrimų sričių, tokių kaip fuzzy logika ir genetiniai algoritmai, atsiradimas.

Grįžimas prie praktinių taikymų: ekspertų sistemos

Vienas pagrindinių dirbtinio intelekto renesanso veiksnių buvo ekspertų sistemų – programų, skirtų spręsti specifines užduotis naudojant ekspertų žinias – plėtra. Šios sistemos naudojo vadinamąsias taisyklių bazes, kuriose žinios buvo saugomos „jeigu–tada“ taisyklių forma.

Ekspertų sistemų pasiekimai:

- DENDRAL (chemijoje): Sukurta 7-ajame dešimtmetyje ir patobulinta 9-ajame dešimtmetyje. Ši sistema padėjo chemikams analizuoti ir interpretuoti duomenis apie molekulių struktūras.

- MYCIN (medicinoje): Ši sistema specializavosi infekcinių ligų diagnostikoje ir antibiotikų gydymo pasiūlymuose. Nors ji niekada nebuvo komerciškai naudojama, jos principai įkvėpė daugybę kitų programų.

- XCON (pramonėje): Ekspertų sistema XCON (dar žinoma kaip R1) padėjo konfigūruoti VAX kompiuterius „Digital Equipment Corporation“ įmonėje. Ši sistema įmonei sutaupė milijonus dolerių ir tapo vienu pirmųjų komerciškai sėkmingų dirbtinio intelekto projektų.

Privalumai ir apribojimai: Ekspertų sistemos turėjo didelę praktinę reikšmę, tačiau jų kūrimas buvo ilgas ir reikalavo daug rankinio darbo. Taisyklių kūrimas reikalavo glaudaus programuotojų ir ekspertų bendradarbiavimo, o tai ribojo jų lankstumą. Be to, sistemos negalėjo savarankiškai mokytis ir prisitaikyti prie naujų sąlygų.

Neuroninių tinklų atgimimas

Kitas svarbus šio laikotarpio momentas buvo neuroninių tinklų tyrimų atnaujinimas, kurie laikinai buvo palikti po Marvino Minsky ir Seymouro Paperto kritikos knygoje „Perceptrons“ (1969). Reikšmingas lūžis įvyko po kelių atradimų:

Atgalinio klaidų plitimo algoritmo atradimas:

- 1986 m. Davidas Rumelhartas, Geoffrey Hintonas ir Ronaldas Williamsas paskelbė straipsnį, kuris atnaujino susidomėjimą daugiasluoksniais neuroniniais tinklais. Atgalinio klaidų plitimo algoritmas leido efektyviai mokyti sudėtingesnius modelius ir atvėrė naujas galimybes atpažinimo bei mašininio mokymosi srityse.

Praktiniai pritaikymai:

- Neuroniniai tinklai pradėti naudoti tokiose užduotyse kaip rašto atpažinimas, ekonominių tendencijų prognozavimas ir vaizdinių duomenų analizė. Nors tai buvo palyginti paprastos taikymo sritys pagal dabartinius standartus, jos reiškė reikšmingą pažangą.

Naujos kryptys: fuzzy logika ir genetiniai algoritmai

Be ekspertų sistemų ir neuroninių tinklų, tuo metu pradėti plėtoti ir kiti metodai:

Fuzzy logika:

- Lotfi Zadeh sukurta fuzzy logika leido mašinoms dirbti su neaiškiais ir dviprasmiškais duomenimis. Ji sėkmingai naudota pramoninėse sistemose, pavyzdžiui, energijos suvartojimo valdymui ar buities prietaisuose (pvz., „protinguose“ skalbimo mašinų režimuose).

Genetiniai algoritmai:

- Šie algoritmai, įkvėpti biologinės evoliucijos, imitavo natūralios atrankos procesus, siekiant optimizuoti sudėtingų problemų sprendimus. Genetiniai algoritmai buvo naudojami, pavyzdžiui, robotikoje ir sudėtingų sistemų projektavime.

Skaičiavimo pajėgumų augimas ir duomenų prieinamumas

9-ajame ir 10-ajame dešimtmečiuose vyko greitas skaičiavimo technologijų vystymasis. Kompiuterių našumo augimas ir didesnių duomenų rinkinių prieinamumas leido testuoti ir diegti sudėtingesnius dirbtinio intelekto modelius.

Superkompiuteriai ir lygiagretus skaičiavimas:

- Superkompiuterių kūrimas ir pažanga lygiagrečių duomenų apdorojimo srityje leido greitesnes ir efektyvesnes simuliacijas.

Pirmosios didelės duomenų rinkmenos:

- Šiuo laikotarpiu pradėta kurti pirmosios organizuotos duomenų rinkmenos (pvz., vaizdų ar kalbos atpažinimui), kurios tapo mašininio mokymosi modelių mokymo pagrindu.

Dirbtinio intelekto komercializacijos augimas

9-ojo dešimtmečio pabaigoje ir 10-ajame dešimtmetyje padidėjo susidomėjimas komerciniu dirbtinio intelekto taikymu. Įmonės pradėjo investuoti į tyrimus ir plėtrą, o kai kurios programos tapo plačiai naudojamos:

Kalbos atpažinimas:

- Tokios įmonės kaip IBM ir „Dragon Systems“ sukūrė pirmąsias komerciškai prieinamas balso atpažinimo sistemas. Nors jos turėjo apribojimų, jos padėjo pagrindą šiuolaikiniams asistentams, tokiems kaip Siri ir Alexa.

AI bankininkystėje ir finansuose:

- AI pradėta naudoti sukčiavimo aptikimui, portfelių valdymui ir rinkos duomenų analizei.

Dirbtinio intelekto renesansas 1980–2000 m. paruošė dirvą moderniam AI. Nors bendrojo intelekto ambicijos nebuvo pasiektos, daugybė praktinių taikymų parodė, kad dirbtinis intelektas turi didžiulį potencialą sprendžiant specifines problemas. Atnaujintas susidomėjimas neuroniniais tinklais ir naujų technologijų, tokių kaip fuzzy logika ir genetiniai algoritmai, kūrimas parodė, kad dirbtinio intelekto tyrimai yra lankstūs ir prisitaikantys. Šis laikotarpis padėjo pamatus dirbtinio intelekto plėtrai ateinančiais dešimtmečiais, ypač dėl didėjančio kompiuterių našumo ir naujų mašininio mokymosi metodų.

Naujasis amžius: Mašininis mokymasis ir gilusis mokymasis (2000–2020)

Laikotarpis tarp 2000 ir 2020 metų žymi esminį lūžį dirbtinio intelekto istorijoje. Po metų eksperimentų ir technologinių apribojimų, DI įžengė į naują etapą dėl mašininio mokymosi (machine learning) ir gilaus mokymosi (deep learning). Šios dvi paradigmos pakeitė požiūrį į tai, ką dirbtinis intelektas gali padaryti, ir atnešė daug praktinių programų, kurias šiandien naudojame kasdieniame gyvenime.

Pagrindiniai naujos eros atsiradimo veiksniai

Didieji duomenys:

Interneto, socialinių tinklų ir išmaniųjų įrenginių plėtra sukūrė didžiulius duomenų kiekius. Šie duomenys, žinomi kaip Didieji Duomenys (Big Data), suteikė dirbtiniam intelektui "kuro" mokytis ir spręsti sudėtingas užduotis. Pavyzdžiui, tokios paslaugos kaip „Google“, „Facebook“ ir „Amazon“ pradėjo rinkti naudotojų duomenis ir optimizuoti savo sistemas naudodamos DI.

Skaičiavimo galia:

Eksponentinis skaičiavimo galios augimas leido greitai apdoroti didelius duomenų kiekius. Specializuotų lustų, ypač grafinių procesorių (GPU) ir vėliau TPU (Tensor Processing Unit) iš „Google“, kūrimas žymiai pagreitino giliųjų neuroninių tinklų mokymą.

Nauji algoritmai ir technikos:

Pažanga algoritmuose, ypač giluminiame mokymesi, atvėrė naujas galimybes. Tokių modelių kaip konvoliuciniai neuroniniai tinklai (CNN) ir rekurentiniai neuroniniai tinklai (RNN) plėtra sukėlė revoliuciją vaizdų ir teksto apdorojime.

Mašininis mokymasis: žinių automatizavimas

Mašininis mokymasis tapo šiuolaikinio dirbtinio intelekto šerdimi. Vietoj rankinio taisyklių programavimo, kuris buvo įprastas ankstesniais dešimtmečiais, mašinos pradėjo savarankiškai mokytis iš duomenų.

Prižiūrimas mokymasis (Supervised Learning):

Šis metodas apima modelių mokymą su duomenų rinkiniais, kurie turi įvestis ir atitinkamas išvestis. Pavyzdžiui:

- Veidų atpažinimas saugumo programose.

- Nekilnojamojo turto kainų prognozavimas remiantis istoriniais duomenimis.

Neprižiūrimas mokymasis (Unsupervised Learning):

Čia modeliai analizuoja duomenis be iš anksto apibrėžtų išvesties duomenų. Šios technikos naudojamos, pavyzdžiui:

- Klientų elgsenos analizėje.

- Anomalijų aptikime finansinėse operacijose.

Sustiprintas mokymasis (Reinforcement Learning):

Šis metodas leidžia mašinoms mokytis per bandymus ir klaidas. Sėkmingai pritaikytas, pavyzdžiui:

- „DeepMind“ sukurtas „AlphaGo“ žaidimas, kuris nugalėjo meistrus Go žaidime.

- Autonominiuose automobiliuose, kur modeliai optimizuoja savo sprendimus remdamiesi jutiklių duomenimis.

Gilusis mokymasis: neuroninių tinklų revoliucija

Gilusis mokymasis, pažangi mašininio mokymosi forma, pagrįsta giliaisiais neuroniniais tinklais, sukėlė DI revoliuciją. Šis metodas leido mašinoms apdoroti sudėtingus duomenis, tokius kaip vaizdai, garsai ir tekstai, su iki tol neregėtu tikslumu.

Konvoliuciniai neuroniniai tinklai (CNN):

CNN tapo standartu vaizdo duomenų analizei. Jie buvo esminiai tokiose projektuose kaip „Google Photos“, veidų atpažinimas „Facebook“ arba autonominis automobilių vairavimas (pvz., „Tesla“).

Rekurentiniai neuroniniai tinklai (RNN) ir LSTM:

Šie modeliai specializuojasi sekos duomenų, tokių kaip tekstas ar garsas, apdorojime. Naudojami, pavyzdžiui, vertimo sistemose („Google Translate“), automatinio rašymo programose („SwiftKey“ klaviatūra) arba sentimentų analizėje socialiniuose tinkluose.

Generatyviniai modeliai (GAN ir GPT):

Generatyviniai tinklai, tokie kaip „Generative Adversarial Networks“ (GAN) ir GPT (Generative Pre-trained Transformer) modeliai, suteikė DI gebėjimą kurti. GAN naudojami realistiškų vaizdų kūrimui, o GPT modeliai, tokie kaip GPT-3, pakeitė automatizuoto teksto apdorojimo pasaulį.

Mašininio ir gilaus mokymosi taikymas

Kalbos atpažinimas ir balso asistentai:

Mašininis mokymasis leido sukurti balso asistentus, tokius kaip „Siri“, „Alexa“ ir „Google Assistant“. Šie įrankiai tapo neatsiejama šiuolaikinio gyvenimo dalimi, nuo išmaniųjų namų valdymo iki informacijos paieškos.

Natūralios kalbos apdorojimas (NLP):

NLP algoritmai leido sukurti pažangius pokalbių robotus, automatizuotas vertimo paslaugas ir sentimentų analizę rinkodaroje.

Autonominis vairavimas:

Gilusis mokymasis yra pagrindinė technologija autonominiams automobiliams, kurie apdoroja duomenis iš kamerų, radarų ir kitų jutiklių, kad galėtų naviguoti realiame pasaulyje.

Sveikatos priežiūra:

DI pradėtas taikyti ligų diagnostikoje, rentgeno nuotraukų analizėje ir naujų vaistų kūrime. Pavyzdžiui, per COVID-19 pandemiją DI sistemos buvo naudojamos viruso genomo analizei ir vakcinų kūrimo paspartinimui.

Pramogos ir medijos:

„Netflix“ ir „Spotify“ naudoja mašininį mokymąsi turinio rekomendacijų personalizavimui, o GAN ir kiti generatyviniai modeliai taikomi kuriant realistiškus specialiuosius efektus.

Svarbūs įvykiai (2000–2020)

2006: Giluminio mokymosi atgimimas:

Geoffrey Hinton ir jo komanda publikavo proveržio tyrimus giluminių neuroninių tinklų mokyme.

2012: „AlexNet“ pergalė:

Alex Krizhevsky sukurtas neuroninis tinklas „AlexNet“ laimėjo „ImageNet“ vaizdo atpažinimo konkursą ir parodė, kad gilusis mokymasis pranoksta ankstesnius metodus.

2016: „AlphaGo“ nugalėjo Go čempioną:

„DeepMind“ sukurtas „AlphaGo“ sistema nugalėjo geriausią šio sudėtingo stalo žaidimo žaidėją, parodydamas sustiprinto mokymosi galią.

2018: GPT-2 ir BERT atsiradimas:

Šie modeliai sukėlė revoliuciją natūralios kalbos apdorojime ir leido pažangias programas tekstų generavime bei kalbos analizėje.

Iššūkiai ir ateitis

Nors laikotarpis 2000–2020 atnešė didžiulę pažangą, atsirado ir naujų iššūkių:

DI etika:

DI sistemos gali atspindėti duomenyse esančius šališkumus, kas gali lemti neteisingus sprendimus, pavyzdžiui, darbuotojų atrankoje ar paskolų teikime.

Skaidrumas:

Gilieji neuroniniai tinklai dažnai laikomi "juodosiomis dėžėmis", o tai reiškia, kad jų sprendimų priėmimas nėra lengvai suprantamas.

Energijos sąnaudos:

Didelių DI modelių, tokių kaip GPT-3, mokymas reikalauja didžiulių skaičiavimo išteklių ir energijos, kas kelia klausimų dėl tvarumo.

Laikotarpis 2000–2020 žymėjo dirbtinio intelekto revoliuciją. Mašininis mokymasis ir gilusis mokymasis leido praktiškas programas, kurios transformavo visą pramonę ir žmonių kasdienį gyvenimą. Šios technologijos atnešė naujas galimybes, bet taip pat iškėlė etikos, skaidrumo ir tvarumo klausimus, kurie formuos būsimą DI vystymąsi.

Dabartis ir ateitis DI

Šiandien DI taikoma visuose gyvenimo aspektuose – nuo sveikatos priežiūros ir transporto iki pramogų industrijos. Tokie asistentai kaip „Siri“ ar „Alexa“, savarankiškai vairuojantys automobiliai ar genomų analizės įrankiai yra tik keli pavyzdžiai. Tačiau kartu kyla ir iššūkių, susijusių su etika, saugumu ir DI reguliavimu.

DI ateitis yra neaiški, tačiau viena aišku: jos vystymasis paveiks tai, kaip žmonija suvokia technologijas, save ir pasaulį aplink mus.

Išvada

Dirbtinio intelekto istorija yra žmonių troškimo suprasti ir kurti įrodymas. Nuo teorinių pagrindų iki praktinių pritaikymų DI nuėjo ilgą kelią – ir jos istorija tikrai nesibaigia. Kiekvienas naujas žingsnis priartina mus prie to, kad ne tik suprastume, kas yra intelektas, bet ir taptume jo bendraautoriais.